Приблизительно 2.5 миллиарда человек на планете ежемоментно находится в интернете, и с каждым годом, месяцем, днем это количество неуклонно растет, как в абсолютном отношении, так и в процентном. Больше пользователей, больше подключенных к сети устройств, больше онлайн сервисов порождают все нарастающее количество трафика, который курсирует по интернет-магистралям проложенным вокруг всей Земли. Так званный "Взрыв каналов", что вспоминается в одном из аналитических отчетов IEEE (Institute of Electrical and Electronics Engineers), привел к ситуации когда наблюдается "дефицит" пропускных мощностей. Недостаточный рост ввода в эксплуатацию новой ИТ-инфраструктуры это прямой путь к падению скорости доступа к сети рядовыми пользователями.

Как известно, по законам экономики, нехватка товара или услуги, зачастую порождает на нее "ажиотаж", а это уже естественно отображается на ценах по которым она предоставляется. Более того ситуация отягощена тем обстоятельством, что порою пользователь, привыкший к дешевизне интернета, фактически не в силах отказаться от использования привычных сервисов, интернет ресурсов, сложившегося на их основе образа жизни. Согласно представленному отчету IEEE, неблагоприятная тенденция в связке трафик-инфраструктура, существует еще с 2010 года и в самом ближайшем будущем она может вылиться в события глобального масштаба, главным из которых можно назвать серьезный передел существующего ИТ-рынка. Так ли все плачевно, как предвидят специалисты уважаемой институции, и есть ли еще возможность "сгладить" последствия скачка человечества в мир "большего трафика", об этом и пойдет далее разговор в представленной статье.

Находясь на должности начальника отдела по оценке пропускной способности сетей в IEEE, а также будучи бывшим главой подразделения, того же IEEE, по развитию инфраструктуры на основе интернет каналов 40 - 100 Гб/сек - Джон Д`Амброзия, является человеком, что стоит в авангарде продвижения идей радикального увеличения пропускной способности ИТ-инфраструктуры. Занимая разного рода позиции в организациях, сообществах, деятельность которых направленна непосредственно на создание и эксплуатацию современной ИТ-инфраструктуры, этот человек весьма авторитетно обосновывает свою позицию.

"Это тот вопрос который не дает мне спокойно спать по ночам", - говорит Джон, являясь к уже упомянутым "титулам" еще и главой промышленной группы Ethernet Alliance. "В своей деятельности я часто попадал в абсурдную ситуацию, когда заканчивая проект, скажем 100 Гигабитного интернет канала, мы уже в этот момент сталкивались с необходимостью его расширения. Не успевав за реальностью наше планирование, при сложно предсказуемых потребностях пользователей интернет магистралей, в условиях радикального роста трафика, зачастую приводило к повторным затратам на усовершенствование только что сданных объектов, что естественно отображалось на прибыли компании и ложилось грузом дополнительных расходов на потребителях".

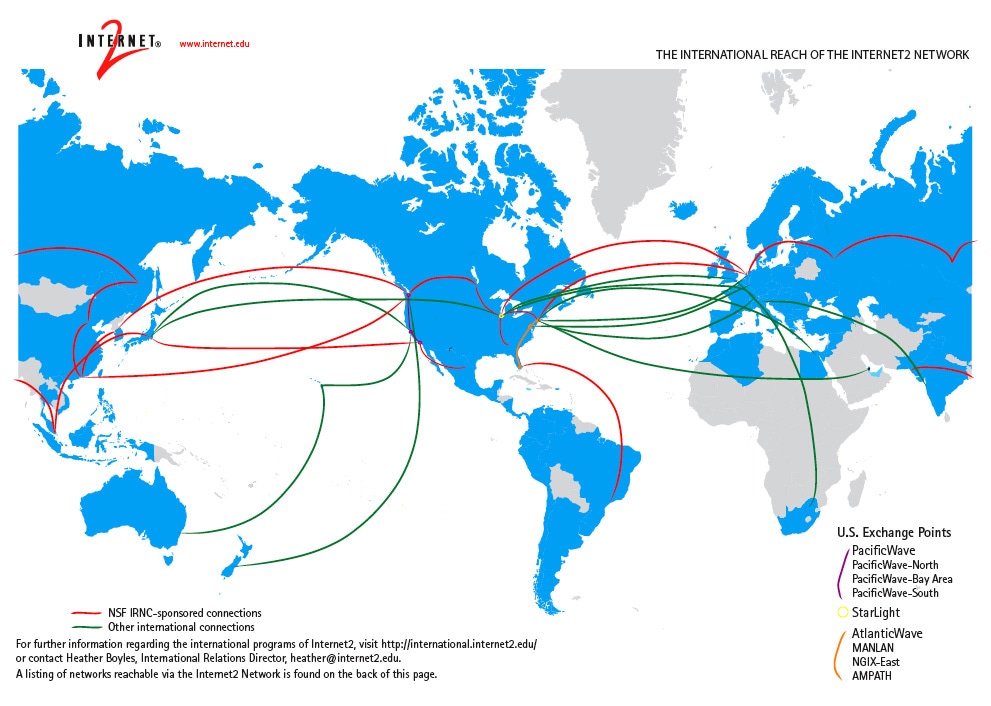

Также когда речь зашла о точках в которых возможно будет переломить сложившееся положение вещей Джон отметил: "Главное на что нам сейчас остается уповать, так это технологический прогресс, уже сейчас есть не мало организаций которые используют интернет и сетевую инфраструктуру качественно следующего уровня. Непрекращающиеся разработки в этом направлении, программируемые параметры сети плюс увеличение инвестиций в подводные интернет каналы и конечно же интернет 2, это те направления в развитии, что помогут нам сгладить последствия от "Взрыва каналов", который мы наблюдаем".

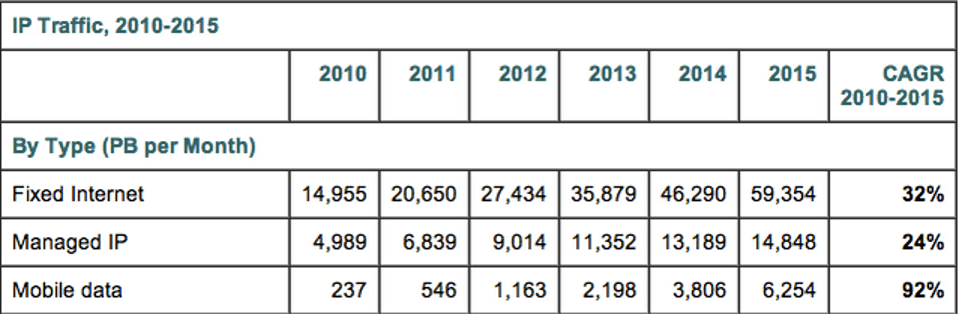

Для ответа на этот вопрос необходимы статистические данный и они есть. Благодаря такой уважаемой организации как Cisco и их индексу VICN (Visual Index Cisco Networking) мы можем заглянуть прошлое интернет трафика и сопоставим с теперешним, довольно корректно, спрогнозировать обозримое будущее. Проанализировав существующие отчеты Cisco начиная с 2010 года и вплоть до 2015 года можно проследить весьма интересную закономерность роста мирового трафика. Если на заре десятых годов исследователи фиксировали до 20.2 Эксабайт ежемесячной генерации трафика и до 242 Эксабайт в ежегодном исчислении, то через пять лет трафик фактически увеличился в четыре раза. Состоянием на 2015 год по существующему прогнозу, опирающемуся на имеющуюся динамику, в конце года приблизимся в плотную к отметке 966 Эксабайт (без малого 1 Зетабайт). Данный объем трафика можно было бы породить, если скажем каждые четыре минуты транслировать через сеть все когда-либо снятые человечеством фильмы.

Учитывая тот факт, что 1 Эксабайт равняется 1 х 1 000 Петабайт, либо же 1 х 1 000 000 Терабайт, становится еще более очевидным тот огромный груз, что лег на существующие информационные магистрали.

Больше пользователей в сети - больше трафика, эта простая истина особо остро проявила себя в последние годы. Весьма неожиданную статистику показали обычные "домашние" потребители интернета. По оценкам исследователей Cisco нужды потребителей домашних хозяйств в развитых странах в 2015 году уже достигли отметки 1 Терабайт трафика в месяц. С таким высоким показателем и впечатляющим количеством пользователей они ворвались в топ наиболее прожорливых потребителей интернет каналов.

Множество интернет-сервисов несут на себе ответственность за Петабайты порожденных данных, но пальма первенства, конечно же, остается за видео. Уже в 2010 году видео вышло на первое место по генерации трафика в сети, огромную роль тут сыграли файлообменники и торренты. В 2015 году ситуация еще больше усугубилась, по весьма компетентным оценкам транспортировка разного рода видео материалов через сеть создаст более 50% всего мирового трафика. Если перевести этот объем в более осязаемые понятия, то его можно сопоставить с тремя миллиардами DVD дисков, либо же с одним миллионом минут видео пропускаемым через сеть за всего лишь одну секунду.

"В данном случае генерация трафика растет уже не столько за счет привычных нам ранее видео материалов, сколько за счет потокового видео, основная часть которого генерируется бурно плодящимися приложениями, набирающими все более широкую популярность - видеоконференциями", - основываясь на годах исследований озвучил такую мысль Томас Барнет (Thomas Barnett) - менеджер по поставке услуг предлагаемыми компанией Cisco.

Также одной из причин породивших "Взрыв каналов" стала массовая доступность смартфонов и планшетов с возможностью использования широкополосного бесконтактного подключения. Как свидетельствует аналитика Cisco уже в 2016 году количество активных мобильных устройств на планете превысит число жителей, достигнув количественной отметки в 10 миллиард штук.

Находясь на гране технологической катастрофы, банальной невозможностью удержать под контролем увеличение потоков трафика, ИТ-компании, а также исследовательские институты, на протяжении последних лет, пытаются переломить ситуацию и не допустить коллапса ИТ-инфраструктуры. Давайте же более детально остановимся на тех инструментах, которыми уже обладаем и наработками, которые могут кардинально изменить весьма угрюмую перспективу утонуть в Зетабайтах данных.

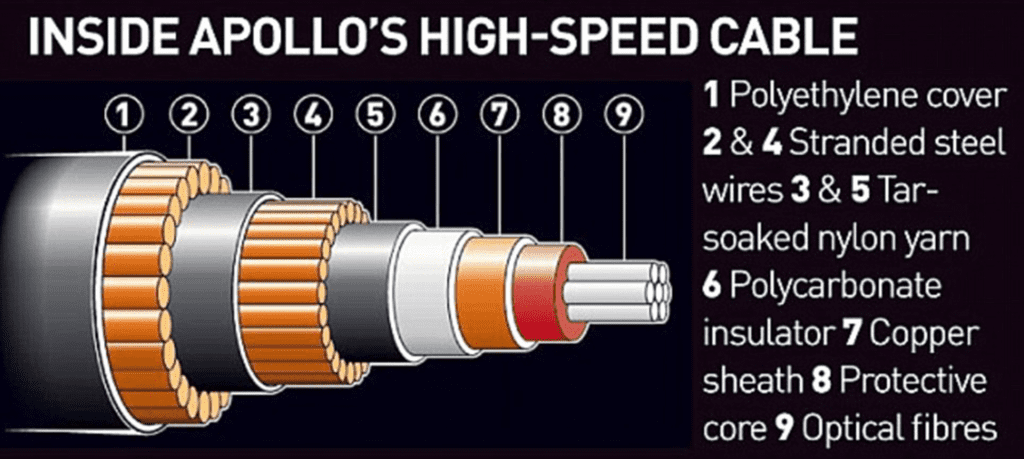

С широким распространением беспроводных технологий у рядовых пользователей сети возникает иллюзия, что кабельная инфраструктура отходит в прошлое, но это конченое не так. WiFi сети в домах, парках и метро это всего навсего крохотная вершина айсберга когда вопрос доходит до реальной сетевой инфраструктуры.

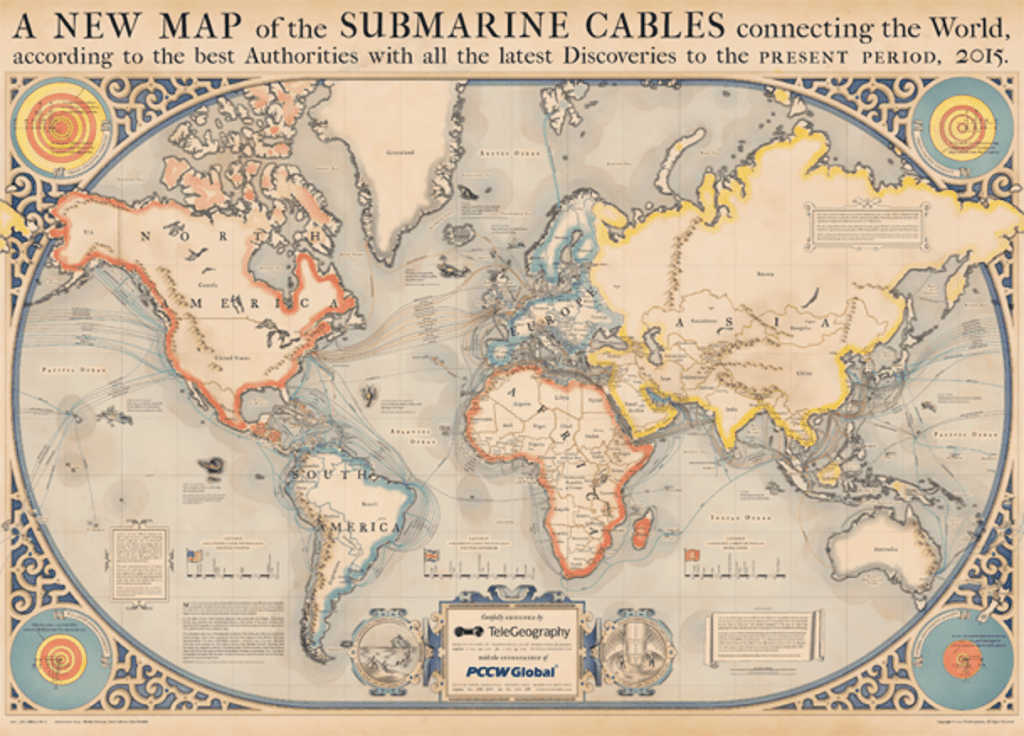

"Беспроводной интернет таким является ровно до того момента пока от мобильного оборудования не дойдет до базовой станции и тут уже начинается совершенно другая история", - говорит Алан Молдин (Alan Moauldin) - директор исследовательской компании TeleGeography. "Какими бы удобными небыли бесконтактные соединения, оптико-волоконные коммуникационные сети были, есть и будут в обозримом будущем становым хребтом ИТ-инфраструктуры. Кабели под землей, под толщей воды уже заковали в свои объятия всю Землю и альтернативы этому сейчас нет"

Компания Алана Молдина непосредственно занимается исследованием развития подводных ИТ-магистралей и имеющиеся у них данные по росту пропускных мощностей очень оптимистические. Проложенные под всеми мировыми океанами кабеля нацелены на решение проблемы с переброской трафика не столько между локальными площадками, как между регионами мира. Это применение во многом и обусловливает их гигантскую пропускную возможность, объем инвестиций и тот размах по вводу в строй новых линий сообщения, что мы наблюдаем в последнем десятилетии.

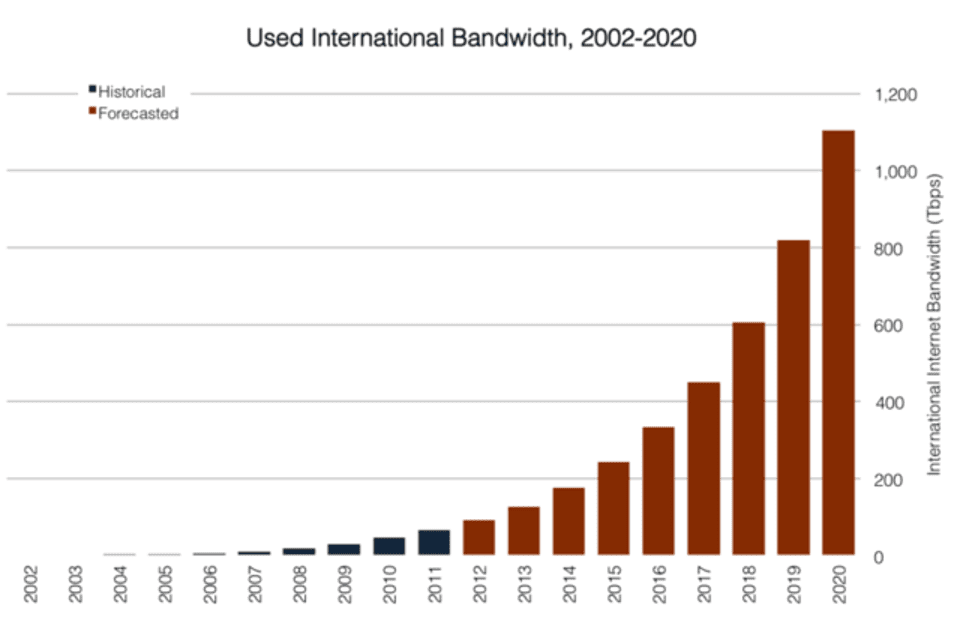

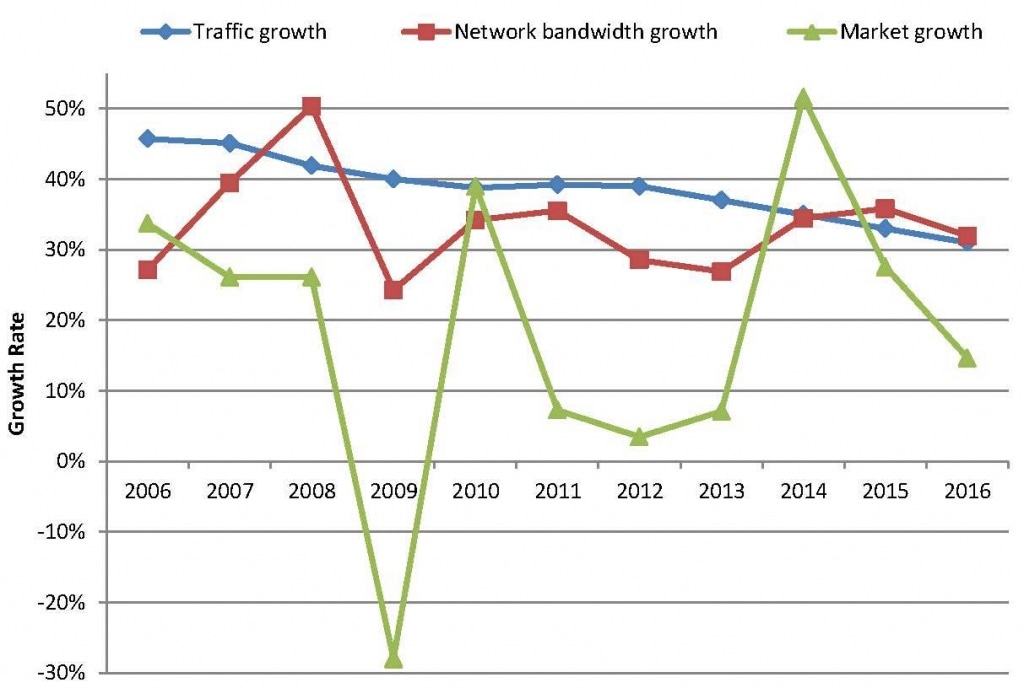

Как можно увидеть на представленном графике, ширина ИТ-магистралей в мире из года в год растет ударными темпами. Начиная с 1.4 Терабит в секунду в 2002 году этот показатель уже в 2006 году поднялся до 6.7 Терабит, сейчас же пропускная способность сетей находится на уровне 200 Терабит. По имеющимся прогнозам к 2020 году через существующие каналы будет возможным транспортировать не менее 1 103.3 Терабит.

Для того чтобы понять проблемы и перспективы роста ИТ-инфраструктуры нужно иметь представления о региональной неравномерности распределения существующих интернет мощностей. Согласно тому же приведенному отчету TeleGeography несменными лидерами списка наиболее развитой инфраструктуры являются конечно же Европа и США. Самым отсталым регионом, даже не смотря на бурное развитие сетей последние годы, стал африканский континент. Состоянием на 2011 год, до всплеска работ по улучшению инфраструктуры черного континента, подводные магистрали обеспечивали скорость всего в районе 700 Гигабит в секунду, к этому моменту Европейский регион обеспечивался каналами с общей скоростью чуть менее 50 Терабит в секунду.

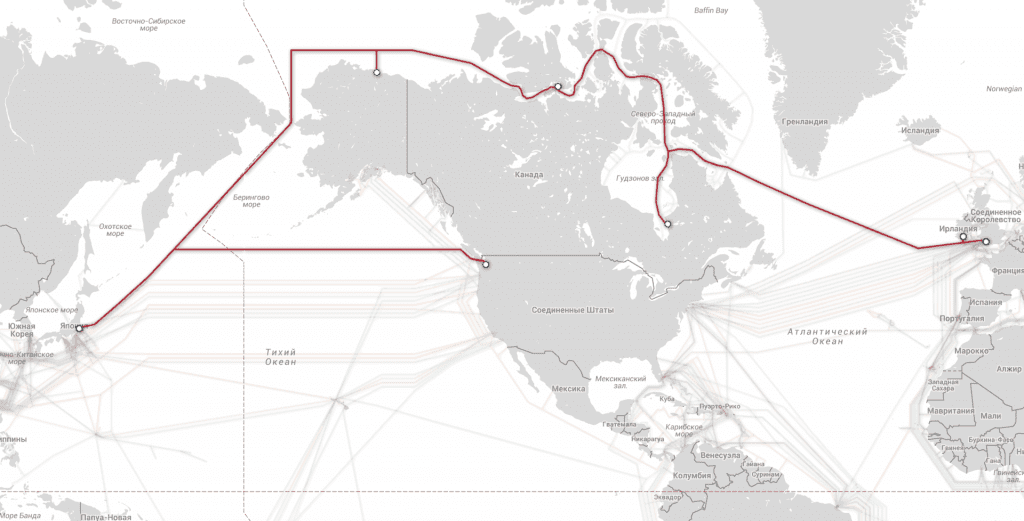

Кроме ширины канала также очень важной характеристикой является задержка сети. Хотя для обычного пользователя интернета не играет особой роли разница PING если она в рамках, скажем 200 мс, но бывают случаи когда каждая миллисекунда на счету. Не так давно был начат проект по прокладке подводного кабеля через регион Арктики, главная цель которого состоит только в том, чтоб снизить задержку сети до 60 мс между Лондонской и Токийской фондовыми биржами, бюджет проекта $1.5 миллиарда, запущена магистраль в эксплуатацию должна будет уже в 2016 году. Также показательным в этом русле стала Южная Америка.

Имея в общем широкие ИТ-магистрали в мир, все они еще до недавно были завязаны на Северную Америку, что отобразилось очень неблагоприятно на задержке сети. Географически находясь всего в 3 тысячах километров от Африки, жители Южной Америки вынуждены были использовать магистрали проходящие через два других континента, но в данный момент с появлением магистралей в южной части Атлантики и Тихого океана ситуация меняется в лучшую сторону.

"Все же проблема коннективности стоит не так уж и остро. Интеграция в цивилизованный мир таких государств изгоев как бывшие страны соц. лагеря, в особенности России, предоставляет возможность соединить Европу и Азию не только через Арктику, но и также по суше, тем самым дополнить новыми "сухопутными" магистралями "подводные". Так как именно с Азиатским регионом у Европы и США наблюдается нехватка ширины интернет каналов", - сформулировал свою мысль Алан Молдин.

Необходимость строительства новых сетей усугубляется еще и тем, что существующие кабели не всегда отвечают требованиям времени и много из ранее проложены уже безвозвратно устарели. По оценки специалистов института IEEE, на данный момент актуальными для максимально эффективного использования остаются магистрали возведенные не далее чем 25 лет назад. "Такие линии сообщения полностью функциональны, но они теряют свой коммерческий эффект", - продолжает Молдин, - "Будущее сетей в плотную связано с развитием технологии "когерентной фильтрации" сигнала". Поляризировав сигнал, а после отфильтровав разные его фазы мы сможем существенно увеличить пропускную возможность существующих магистралей, это та технология, что сможет кардинально разрешить в ближайшем будущем уже сейчас существующий дефицит сетей. Магистрали, первоначально рассчитанные на транспортировку 10 Гб/с данных, можно будет увеличить до 40 и может даже до 100 Гб/с. Все что для этого необходимо это замена оборудования кодирующего/декодирующего сигнал и его усиливающего, сотни тысяч километров самого оптического-волокна, проложенного по всему миру, остается прежним".

Кроме количественного улучшения сети, также необходимо помнить и о ее качественной составной. В данный момент наиболее широкой огласки набирает технология OpenFlow. Данная система оптимизации пересылки пакетов уже успешно применяется как локально, в исследовательских центрах, примером может послужить сеть CERN, так и у коммерчески успешных участников ИТ-рынка, самым ярким примером тут может послужить корпорация Google, применяющая OpenFlow в работе своих дата-центров.

"Нам под силу организовать работу программируемой сети в небольших масштабах", - утверждает Фил ДеМар (Phil DeMar) - сетевой инженер института Ферми, что в штате Иллинойс, США. Упомянутый институт является одним из 11 учреждений, которые получают данные на прямую из CERN. После получения этих данных они дальше передаются в открытую сеть на более чем 160 сайтов 2 уровня приоритетности и в разы большего количества сайтов с более низким уровнем приоритетности. "Если бы не внедренная технология OpenFlow, наша существующая ИТ-инфраструктура была бы просто парализована тем огромным количеством данных, что мы получаем из CERN. Однако не стоит идеализировать упомянутую технологию, это не вершина, а всего лишь первая ступенька к ней". Но когда разговор зашел о возможности массового внедрения технологии программирования сети Фил был несколько скептичен - "Наш институт имеет с CERN две выделенные линии по 10 ГБ/с каждая, и этого нам хватает, однако учитывая все проблемы с внедрением OpenFlow и его поддержания нам было бы менее затратным банально увеличить каналы до 20-30 Гб/с, технология пока не готова к широкому применению".

Для сетевых инженеров конечно не секрет, что принципы на которых базируется привычный нам интернет вообще то не монопольны, программируемая пересылка пакетов по более оптимальным принципам реализована в уже упомянутом OpenFlow. Существование некоммерческого консорциума из исследовательских и производственных институтов - Интернет 2 направлено на модернизацию самих принципов функционирования сети. Особенности развивающейся сети состоят в том, что она уже сейчас функционирует исключительно на основе IPv6, использует широковещательный канал, поддерживает систему приоритетной передачи трафика. Хотя данная сеть и присутствует по большей мере только в США, применяемые в ней нововведения и экспериментальные технологии пройдя обкатку постепенно перекочевывают в привычный нам Интернет.

Ключевым же вопрос остается: сумеет ли технический прогресс переварить порождаемый им же рост объема транспортируемых данных? Ответ на этот вопрос попробовал дать Андрей Одлыжко - профессор Университета Минесоты и бывший начальник сетевого департамента в AT&T: "Я не стал бы сейчас истерить по поводу бесконтрольного роста трафика, факт которого конечно не оспорим. Дело в том, что как то я уже погорел на этой скользкой теме, еще в далеком 1997 году, работая в АT&T. Хотя и прошло почти два десятилетия с тех далеких времен, но сейчас смотрю положение вещей почти не изменилось. Мы тогда, так же как и сейчас, предрекали "сетевой коллапс" в ближайшие 5 лет, мы также констатировали отставание ввода новых сетевых мощностей от роста порождаемой в мире цифровой информации", - с загадочной улыбкой ударился в воспоминание Андрей, - "Но как видите никакого коллапса не произошло. Дополнительные инвестиции в исследования технологий, развитие инфраструктуры, всеобщий технический прогресс с изобретением новых и удешевлением уже существующих материалов помогли отложить "сетевой апокалипсис", который для многих, весьма компетентных людей, был уже сбывшимся фактом. Новое время обязательно принесет новые решения, даже если сейчас нам о них еще ничего не известно", - иронично подытожил Андрей Одлыжко.